精子生于 1995 年,英文 ID jysperm.

2023 年度小结

今年 3 月我和蛋黄一起去了泰国旅行,算是我们两个第一次在国外「自由行」,我们先去拜访了之前一起在番茄土豆工作的朋友们,他们热情地招待了我们,带我们在清迈玩了三天,参观了他们的办公室,还体验了泰式按摩、一起玩狼人杀、爬山。之后我们又去了普吉岛,感受沙滩和大海,在岛上骑摩托车。

在经过几年稳定的工作和疫情封控之后,这是我第一次去体会不一样的生活方式 —— 也许除了在国内一线城市扎根,或者移民发达国家,还可以适当地放弃一些执念,来获得一个更简单的生活。经过这么多年,我也意识到了自己并不是一个喜欢竞争的人,更想要也更适合一个「低竞争」的环境。这时我感觉自己仿佛站在人生的分叉口,要不要考虑去到中国的二线城市或者甚至泰国生活呢?但蛋黄还是很简单地把我劝了回来 —— 毕竟去了加拿大以后还可以后悔回来,但现在躺平的话后悔可就去不了加拿大了。

9 月时我们还去了日本旅行,因为一直以来都在通过各种影视和游戏作品了解日本的生活习惯和文化,所以日本可能是我们最熟悉的国家了,到日本一下飞机果然是这种感觉 —— 真就和我们印象中的日本一模一样。我们在日本去了环球影城的任天堂园区、任天堂商店、藤子·F·不二雄博物馆、秋叶原,哆啦 A 梦和马里奥这些我们所熟知的形象在日本真的是无处不在。日本由新干线、电车和地铁构成的交通网络非常发达,没有安检、换乘方便、区分快慢车,很多商圈也是以一个电车站为中心,但价格确实不便宜,我们在日本总共竟然花了 1200 人民币来乘坐地铁和电车

在日本我们也拜访了一位年初才移居日本的前同事,他们距离东京市中心乘电车大概一个半小时,带我们逛了他们所在的居民区和超时。这里和新宿这样的商业区完全不同,密度比较低,街道非常干净整洁,就像是很多影视作品里的日本小镇。

在经历了 去年的疫情封控 之后,我便下定决心要将我们之前移居加拿大的计划提上日程,并以最高的优先级来执行。在经过了 2022 下半年的调研和准备后,我们决定由蛋黄申请留学签证,我作为配偶申请开放工签的方式移居加拿大。在我们准备签证的过程中,因为公司的一些变化,工作给我带来的压力和不适越来越大,所以在提交了我的签证申请之后,我马上就 离开了 TapTap 和 LeanCloud,准备休息一段时间,然后准备搬家。

在离职之后的这段时间,我开发并发布了 HostedBeans。这是我作为独立开发者的第一个尝试,我希望能利用上之前那么多年的工程经验,设计和开发一些体量较小,但能带来长期价值的产品,也能从中获得收入。

本来我们都已经买了 11 月 11 日的机票,准备带着皮蛋豆腐和所有东西一起搬到加拿大。然而到 9 月时我们发现,我的签证进入到了一个通常耗时半年以上的一个安全审查(Security Screening)的流程中,而蛋黄的开学时间也没法再推迟了。

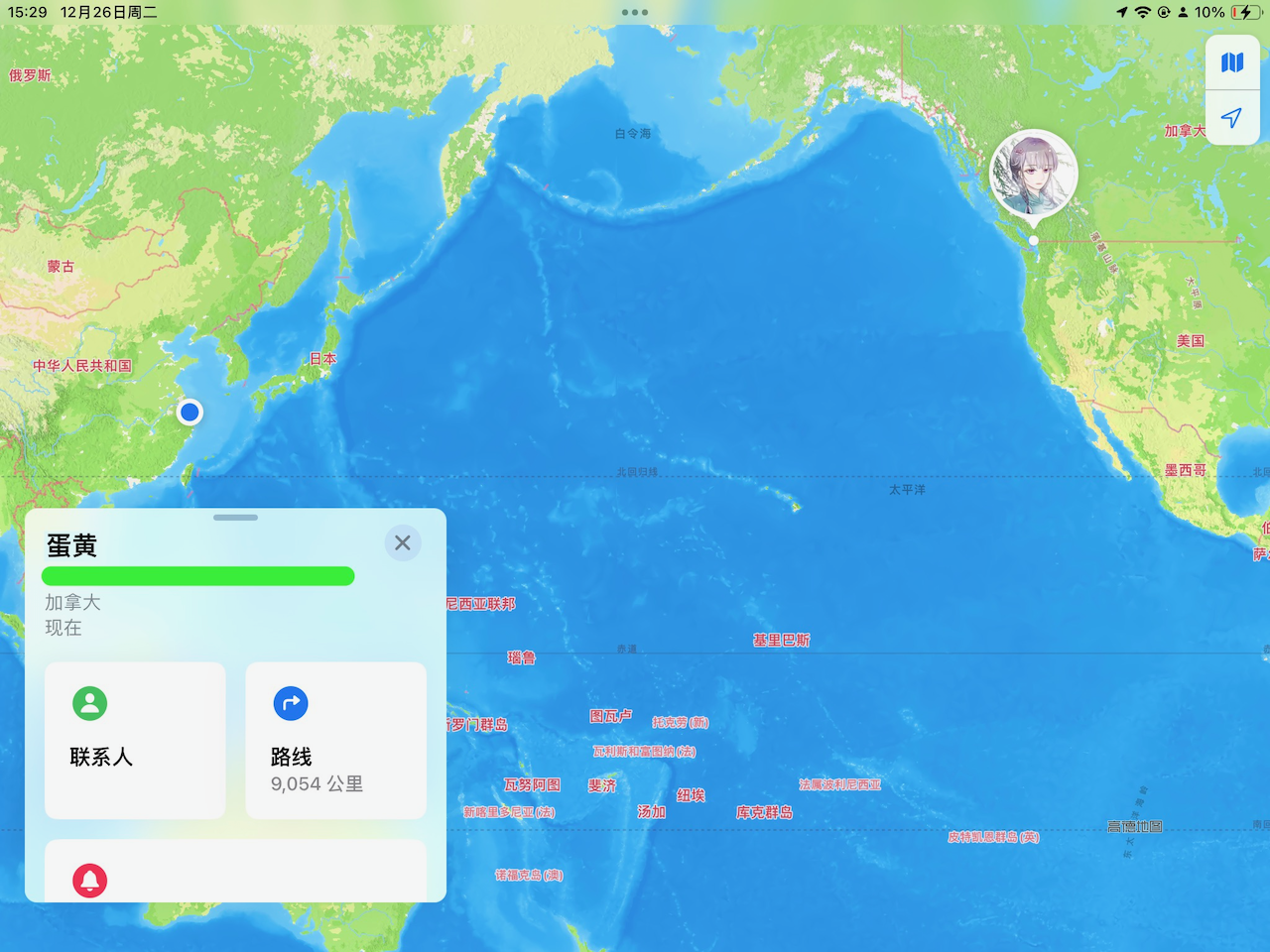

其实在一开始我们就确定了两个人一定要一起出发,不能分开。但现在我们几乎已经走到了最后一步,安全审查除了等待时间比较长,几乎不可能拒签,难道要在这个时候放弃么?我很清楚这段时长并不确定的异地并不是我想要的,会给我们的关系带来很大的考验。但所有的朋友都觉得不能错过这个机会,理性上当然应该这样做,所以蛋黄在 12 月 25 日一个人出发去了加拿大,在 2023 的年底,我们暂时分开。